- Rosjanie pokazali, jak nieinwazyjnie odczytują obrazy z fal mózgowych

- W kolejnym etapie prac planują szersze szkolenie sieci neuronowych

- System ma pomóc sparaliżowanym w rehabilitacji i sterowaniu egzoszkieletem

Czy da się pokazać w czasie rzeczywistym to, co widzi ludzkie oko? Rosyjscy neurobiolodzy twierdzą, że tak i zapewniają, że potrafią to zrobić metodą nieinwazyjną.

Przekładanie mowy na tekst nie jest już dla sztucznej inteligencji niczym niezwykłym. Algorytm odmaluje też w miarę przyzwoicie nasz portret, słuchając tego, jak mówimy. Myślami możemy pisać oraz wydawać polecenia urządzeniom, i to w kilku językach. Sparaliżowani mogą też wzrokiem sterować robotami, spędzając w ten sposób czas na użytecznej pracy.

Teraz sztuczna inteligencja ma pokazać, co widzimy, i wesprzeć chorych m.in. po udarach.

Dość prymitywny?

Naukowcy z rosyjskiej korporacji Neurobotics oraz Moskiewskiego Instytutu Fizyki i Technologii (MIPT) stworzyli interfejs mózg-komputer z połączenia sieci neuronowych z elektroencefalografem (EEG), techniką rejestrowania fal mózgowych za pomocą elektrod umieszczonych nieinwazyjnie na skórze głowy.

Opracowali dwie sieci neuronowe: jedną do generowania losowych obrazów specyficznych dla poszczególnych kategorii, a drugą do generowania podobnych obrazów z sygnałów EEG. Zespół wyszkolił sieci, aby działały razem w sposób, który zamienia sygnał EEG w rzeczywiste obrazy podobne do obserwowanych. Algorytm rozkłada wszystkie obrazy na osobne znaki składowe rozmieszczone w przestrzeni wektorowej, za pomocą których można je następnie skorelować z niektórymi sygnałami mózgu zarejestrowanymi za pomocą EEG.

Adres filmu na Youtube: https://www.youtube.com/watch?time_continue=9&v=nf-P3b2AnZw

Źródło: NeuroboticsRU / YouTube

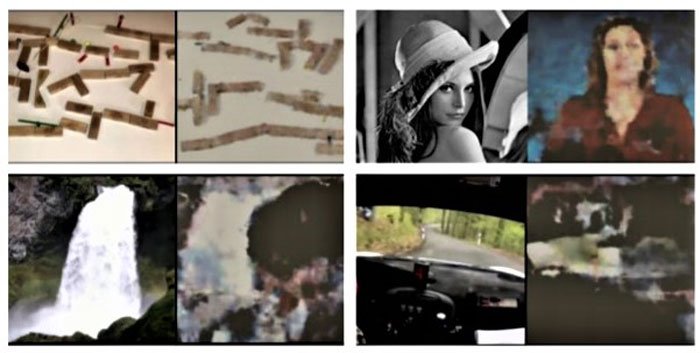

Neurobiolodzy najpierw pokazali zdrowym uczestnikom eksperymentu 20 minut kilkusekundowych (od 6 do 19 s) fragmentów wideo z YouTube z pięciu różnych kategorii, od abstrakcyjnych kształtów po twarze i dynamiczne sporty – filmiki nakręcone przez kierowców skuterów śnieżnych, wodnych, motocykli i sportowych samochodów. Wzorce fal mózgowych z zapisów EEG okazały się różne dla różnych kategorii filmów.

O silniku po spalinach

Następnie badacze wybrali trzy losowe kategorie spośród pięciu wcześniej wytypowanych. Uczestnicy eksperymentu obejrzeli kolejne, wcześniej niewidziane filmy z wytypowanych kategorii.

Fale z EEG oglądających były równolegle przesyłane do sieci neuronowych. System wygenerował przekonujące obrazy, którym prawidłowe odwzorowanie oglądanych filmów można przypisać w 90 procentach przypadków. Sami naukowcy byli zaskoczeni, że fale mózgowe zawierają wystarczające dane, aby choć w części zrekonstruować obserwowany obraz.

„To jak rozszyfrowanie wewnętrznej struktury silnika parowego po analizie pary” – wyjaśnił współautor Grigorij Raszkow, młodszy badacz w MIPT i programista w Neurobotics.

System rekonstruuje obrazy widziane przez osobę z „czepkiem” elektroencefalografu na głowie w czasie rzeczywistym. Ale czy to już czytanie z myśli? Absolutnie nie. Komputer nauczył się określać na podstawie zapisu EEG, który obraz pięciu różnych wcześniej znanych klas widział badany.

Ale Rosjanie twierdzą, że lepiej wyszkolony interfejs pomoże m.in. osobom sparaliżowanym np. kontrolować rehabilitacyjne egzoszkielety czy wózki inwalidzkie. Na dodatek to metoda nieinwazyjna – do takiej w odczytywaniu myśli dąży Elon Musk i jego Neuralink, a także Facebook, choć na razie badania prowadzone są na pacjentach z wszczepionymi chipami.