Autonomicznie sterowane samochody Tesli wkrótce pojawią się w miastach, bo będą w stanie szybko rozpoznawać światła sygnalizacji, znaki drogowe, diagnozować sytuację na skrzyżowaniach, a nawet namierzać niedzielnych kierowców

Tryb autonomicznej jazdy w elektrycznych samochodach Tesli ograniczano dotychczas do autostrad i tras szybkiego ruchu. Dzięki postępom w pracach nad nowym procesorem dla komputera pokładowego liczba operacji wykonywanych w ciągu sekundy ma przewyższać wynik obecnej generacji o nawet 2000 proc.

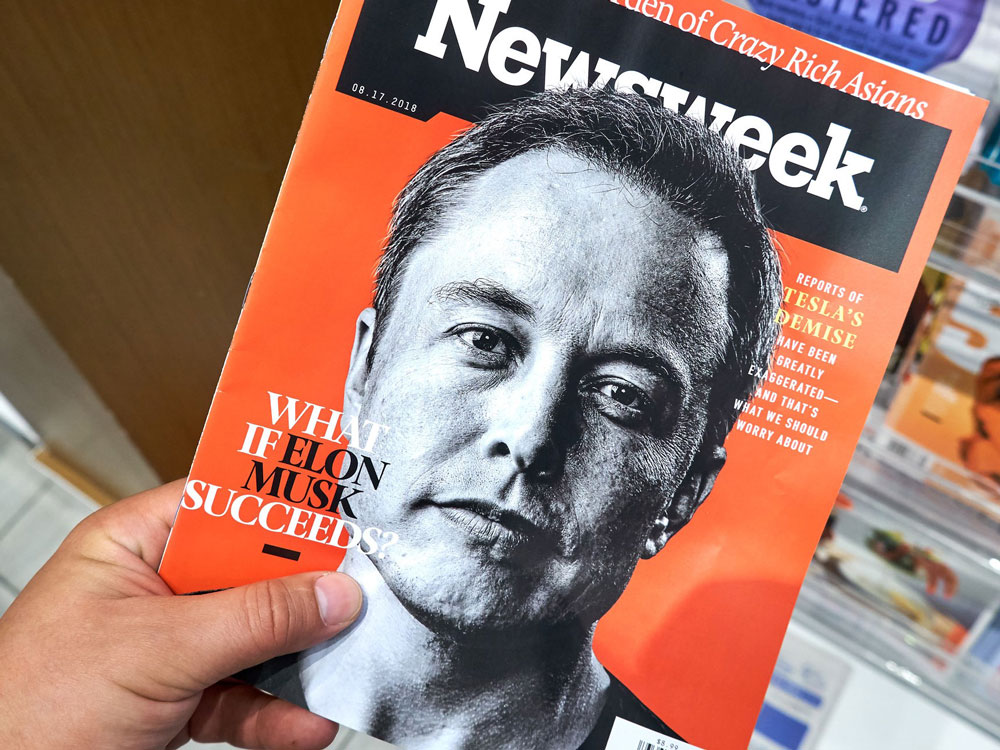

Elon wieszczy, Elon studzi

Z charakterystyczną dla siebie pewnością Elon Musk zapowiada, że będzie to najbardziej zaawansowana na świecie jednostka obliczeniowa przeznaczona do autonomicznej jazdy. Jej serce stanowić ma rozwiązanie typu ASIC (ang. Application-specific integrated circuit – specjalizowany układ scalony) – chip zaprojektowany od podstaw przez inżynierów Tesli, który ostatecznie zakończy 3-letnią współpracę z Nvidią. Obecnie dostępne wersje trybu autonomicznego (Tesla Autopilot 2.0 oraz 2.5) oparto na platformie Nvidia Drive PX2. Musk jest przekonany, że zastąpienie GPU (procesora graficznego) autorskim układem typu ASIC okaże się nie tylko efektywniejsze, ale również tańsze.

Adres filmu na Youtube: https://www.youtube.com/watch?v=7ztK5AhShqU&feature=youtu.be

Źródło: YouTube

Co więcej, każdy posiadacz Tesli z trybem Tesla Autopilot 2.0 oraz 2.5 dostanie nową wersję komputera za darmo, o ile wcześniej zamówił opcjonalny pakiet pełnej autonomii. Wymiana sensorów nie będzie konieczna. Jeśli wszystko pójdzie zgodnie z planem, w pierwszej połowie 2019 roku Tesla Autopilot 3.0 stanie się faktem. Obecnie prowadzone są już testy sprawności systemu rozpoznającego sygnalizację świetlną, znaki drogowe, ronda, a nawet identyfikującego niedzielnych kierowców.

Autonomiczne auta będą rozpoznawać światła sygnalizacji, znaki drogowe, diagnozować sytuację na skrzyżowaniach, a nawet namierzać niedzielnych kierowców

Dotychczas system stosowany przez Teslę mógł w ciągu sekundy przetworzyć 200 klatek obrazu. Nowa wersja jest 10 razy bardziej wydajna. Ponadto do przetwarzania danych ze wszystkich 8 kamer zainstalowanych w aucie po raz pierwszy zaangażowano zunifikowaną sieć neuronową zdolną do obliczeń na dużo większą skalę.

Musk studzi jednak najbardziej podekscytowanych, zastrzegając, że dzień, w którym samochody będą w stanie samodzielnie się prowadzić w dowolnych warunkach, jest jeszcze odległy.

Sześć poziomów autonomii

Według klasyfikacji międzynarodowej organizacji SAE (International Society of Automotive Engineers) wyróżniamy sześć poziomów autonomii jazdy:

Poziom 0: brak automatyzacji – “totalna kontrola” – wymaga pełnej kontroli kierowcy nad autem;

Poziom 1: wspomaganie kierowcy – “ręce na kierownicy, oczy na drogę, umysł na sytuację”. Mamy z tym do czynienia np. w przypadku użycia w samochodzie adaptacyjnei kontrola trakcji, pilnowania pasa ruchu czy asystenta parkowania;

Poziom 2: częściowa autonomia – “ręce z kierownicy, oczy na drogę, umysł na sytuację”. Przykład poziomu 2 to tryby autonomicznej jazdy w rodzaju GM Super Cruise, Mercedes-Benz Drive Pilot, Tesla Autopilot, Volvo Pilot Assist, Nissan ProPilot Assist;

Poziom 3: warunkowa autonomia – “ręce z kierownicy, oczy z drogi (czasami), umysł na sytuację”. Auto podejmuje samodzielne decyzje, np. o zmianie pasa czy w reakcji na dynamiczną sytuację na drodze (tryb Traffic Jam Pilot w Audi A8 Sedan). Pojazd porusza się w korku z prędkością do 60 km/h;

Poziom 4: wysoka autonomia – “ręce z kierownicy, oczy z drogi, umysł na sytuację (czasami). W określonych warunkach auto może całkowicie autonomicznie się prowadzić. Jeśli będzie potrzebowało asysty, powiadomi kierowcę, a jeżeli ten nie zareaguje, automatycznie zjedzie z drogi i zatrzyma się (np. Google i Waymo);

Poziom 5: pełna autonomia – “kierowca jest zbędny”. Pojazd porusza się samodzielnie bez konieczności interwencji kierowcy (nie trzeba kierownicy oraz pedałów przyspieszenia i hamowania).

Obecnie większość systemów autonomicznych w samochodach funkcjonuje na granicy poziomów 2 i 3.

Nvidia stawia na VR

Rozwód z Teslą nie oznacza dla Nvidii porzucenia platformy Nvidia Drive. Firma ma na tym polu ogromne sukcesy i postanowiła zaprząc do pracy wirtualną rzeczywistość. Inżynierowie i programiści mają okazję testować nowe możliwości oprogramowania najpierw w VR, a dopiero potem przesyłać je do rzeczywistych pojazdów.

Adres filmu na Youtube: https://www.youtube.com/watch?v=KS_4xjXNTxg

Źródło: NVIDIA / YouTube

Poligonem testowym jest 80-kilometrowa trasa w Kalifornii składająca się z czterech autostrad połączonych ze sobą w pętlę. W trakcie podróży auto samodzielnie przemieszcza się i zmienia wielokrotnie pas ruchu. Demo zaprezentował szef Nvidii na ostatniej europejskiej odnodze konferencji GTC (GPU Tech Conference) w październiku 2018 r.